[수리통계학] 컨벡스 함수와 젠센 부등식(Convex and Jensen's Inequality)

Review

참고 포스팅 :

[수리통계학] 확률변수의 기댓값(Expectation of Random Variable)

Review참고 포스팅 :2023.09.14 - [Statistics/Mathematical Statistics] - [수리통계학] 확률변수(Random Variable ; R.V.) [수리통계학] 확률변수(Random Variable ; R.V.)Review # 해당 포스팅은 KOCW 김충락 교수님의 수리통계

datalabbit.tistory.com

# 해당 포스팅은 KOCW 김충락 교수님의 수리통계학 강의와 Hogg의 수리통계학개론(Introduction to Mathematical Statistics)를 기초로 작성되었습니다.

안녕하십니까, 간토끼입니다.

지난 포스팅에서 확률변수의 기댓값, 그리고 적률생성함수에 대해 다뤘습니다.

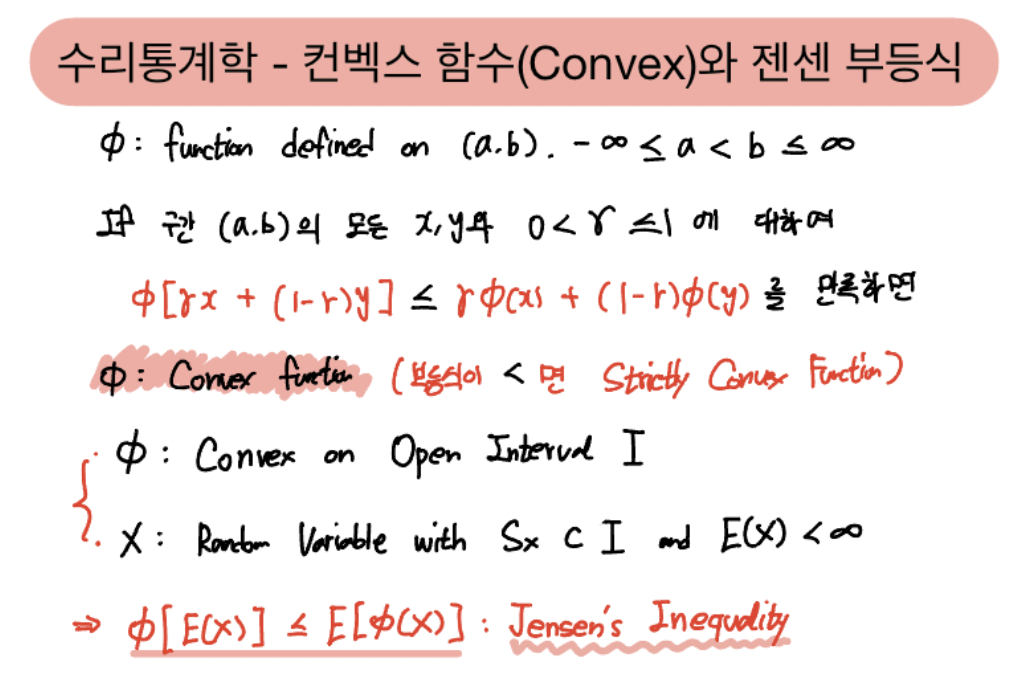

이번 포스팅에서는 기댓값과 관련된 유명한 부등식인 젠센 부등식(Jensen's Inequality), 그리고 이를 설명하기 위해 필요한 컨벡스 함수(Convex Function)에 대해 다뤄보겠습니다.

1. 컨벡스와 컨케이브 함수(Convex and Concave Function)

먼저 젠센 부등식을 다루기 전에 컨벡스 함수에 대해서 알아야합니다.

컨벡스 함수 이전에 컨벡스 셋(Convex Set)에 대해 알면 더 좋겠지만, 내용이 너무 길어지니 생략하겠습니다.

사실 컨벡스 함수는 용어가 생소해서 그렇지 고교 교육과정에서 배웠던 함수입니다.

흔히 말하는 아래로 볼록한 함수(위로 오목한 함수)를 의미합니다.

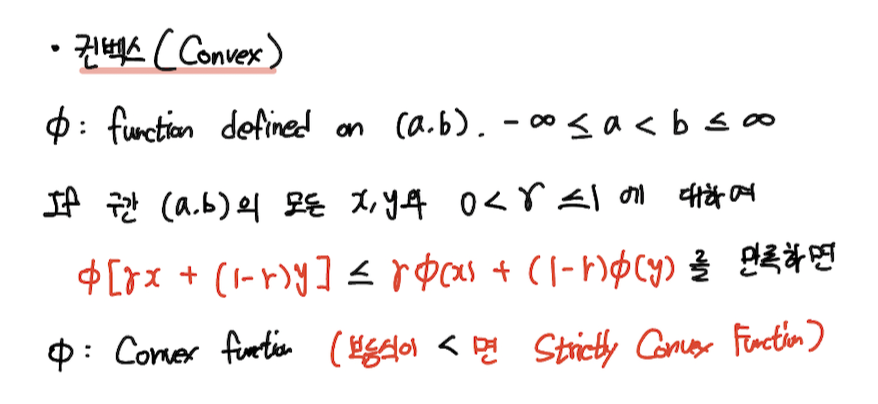

개구간 (a,b)에서 정의된 함수 $\phi$ 를 가정하겠습니다.

만약 구간 (a,b) 내 모든 $x, y$와 $0 < \gamma \leq 1$ 에 대하여 함수 $\phi$가 다음 식을 만족한다면 Convex function이라고 합니다.

$$ \phi [\gamma x + (1-\gamma)y]\, \leq \, \gamma\phi (x) + (1-\gamma) \phi(y) $$

이때 위 식에서 부등식이 < 이면 $\phi$ 는 strictly convex function(순볼록함수)라고 합니다.

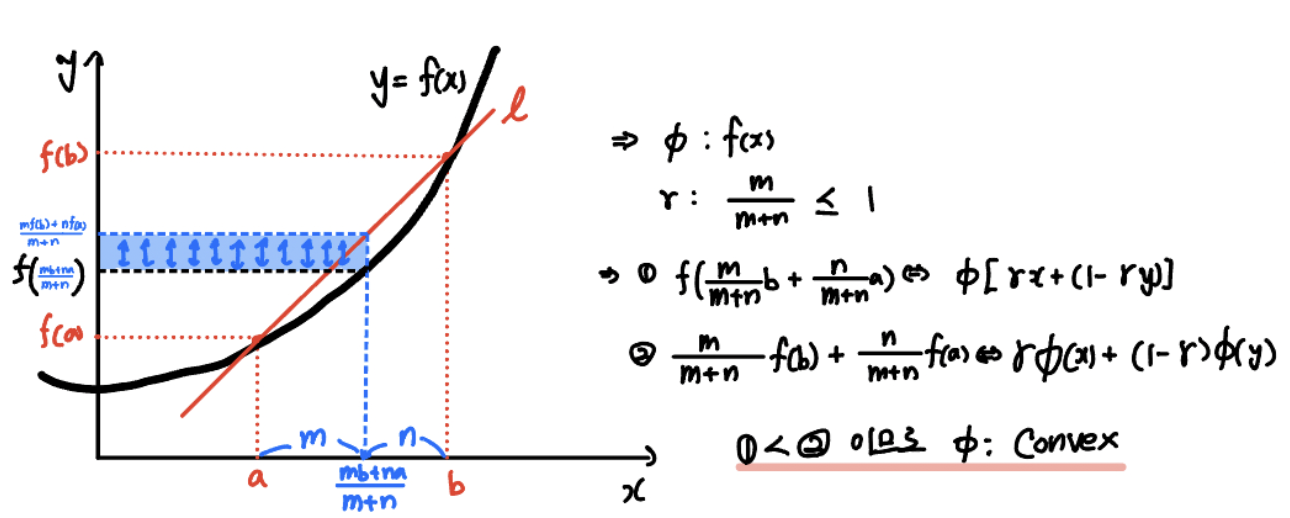

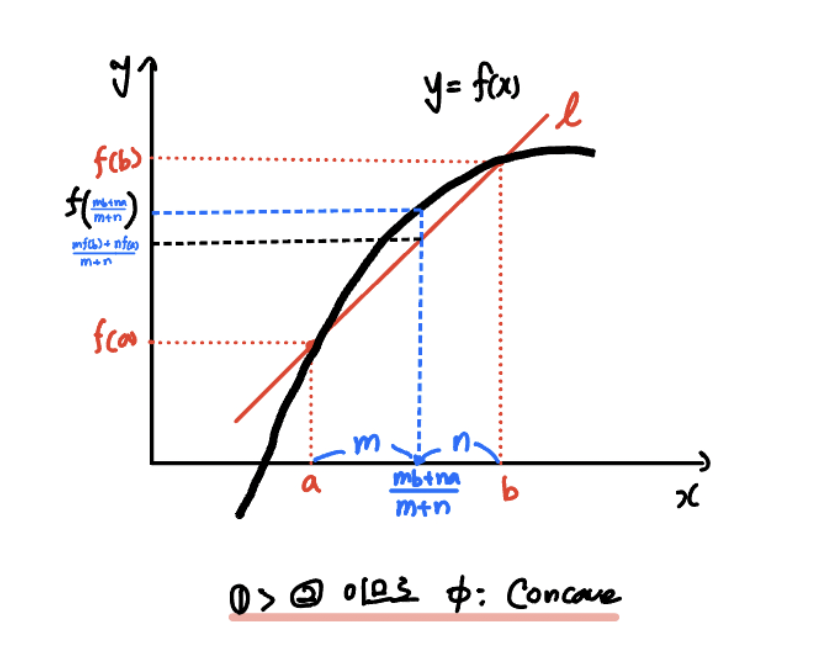

알기 쉽게 그림으로 살펴봅시다.

어떤 함수 $f(x)$를 가정하겠습니다.

우상향하는 꼴이네요. 아래로 볼록한 함수임은 직관적으로 이해가 되실 거라 생각합니다.

이때 $x$ 를 임의의 $a, b$ 라고 하고, $a, b$를 m:n으로 나누는 중점 $\frac{mb+na}{m+n}$ 을 정의하고, 이 값을 위 컨벡스 함수의 조건식에 대입해보겠습니다.

그러면 위 그림에서 알 수 있다시피 식 (1)은 컨벡스 함수값이고, 식 (2)는 $((a,f(a)),\, (b, f(b))$ 를 이은 직선의 방정식 $l$ 상의 값이 되겠으며, 식 (2)의 값이 (1)보다 큰 값임을 알 수 있습니다.

그러므로 함수 $\phi$는 Convex 함수입니다.

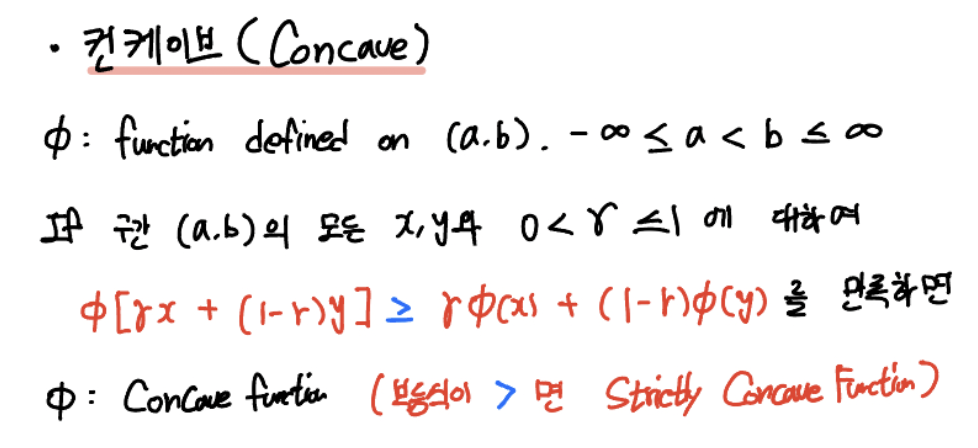

이번에는 Concave Function을 정의해보죠.

Concave는 아래로 오목한 함수입니다.

즉 이름부터 컨벡스와 반대의 개념이니 위 컨벡스 함수에서 조건식의 부등호만 반대로 정의하면 됩니다.

$$ \phi [\gamma x + (1-\gamma)y]\, \geq \, \gamma\phi (x) + (1-\gamma) \phi(y) $$

이때 위 식에서 부등식이 > 이면 $\phi$ 는 strictly concave function(순오목함수)라고 합니다.

마찬가지로 그림으로 이해해봅시다.

보시다시피 위로 볼록한, 즉 아래로 오목한 함수의 꼴입니다.

컨벡스와 다르게 식 (1)이 식 (2)보다 큼을 알 수 있습니다.

그러므로 함수 $\phi$를 Concave Function이라고 합니다.

Convex에 대해 좀 더 알아보겠습니다.

이번에는 임의의 함수(아직 컨벡스인지 모르는) $\phi$가 구간 $(a,b)$에서 미분 가능하다는 가정을 하겠습니다.

그러면 임의의 함수 $\phi$가 다음 조건을 만족할 경우, $\phi$는 Convex function입니다.

크게 1계 미분이 가능한 경우와, 2계 미분이 가능한 경우 2가지를 놓고 판정할 수 있습니다.

만약 $x \leq y$인 경우, $\phi'(x) \, \leq \, \phi'(y)$ 라면 $\phi$는 Convex입니다.

그리고 이 명제는 필요충분한 명제(if and only if ; iff)입니다.

혹은 $\phi$가 임의의 $x$에서 2계 미분한 값이 0보다 크다면, 즉 $\phi'(x) \, \geq \, 0$라면 $\phi$는 Convex입니다. 물론 이 또한 필요충분이므로 Convex라면 이계도함수가 0보다 크거나 같습니다.

그리고 위 두 명제의 부등호에서 = 을 제거하면 순볼록함수(Strictly Convex Function)입니다.

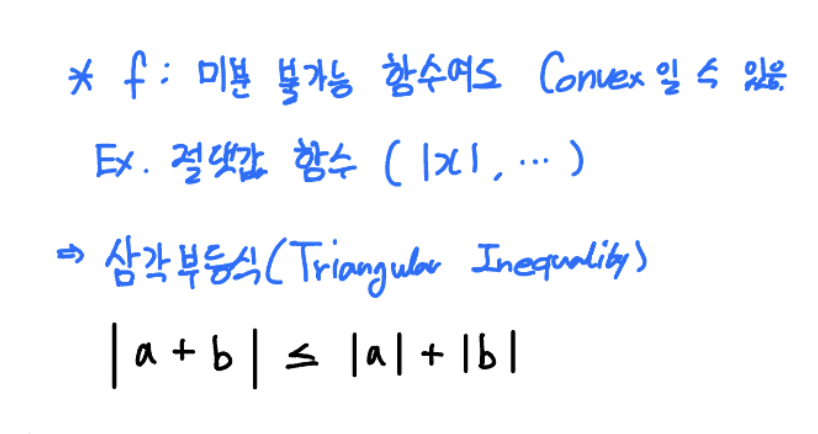

그렇다고 항상 미분 가능해야만 Convex인 것은 아닙니다.

그 예로 절댓값 함수 $\left|x\right|$ 가 있습니다. 이는 원점에서 뾰족점을 가지므로 원점에서 미분 불가능한 함수죠.

그래서 이 컨벡스의 특징을 활용한 삼각 부등식(Triangular Inequality)이 있죠.

(물론 절댓값 함수는 컨벡스이자 동시에 컨케이브이지만 생략하겠습니다.)

어쨌든 미분을 활용하여 컨벡스 혹은 컨케이브임을 판단할 수 있다는 게 핵심이니 이 부분만 잘 기억해주시면 좋을 것 같습니다.

컨벡스 함수는 사실 젠센 부등식을 떠나서 통계학, 그리고 데이터 사이언스를 하기 위해서 알고 있어야 하는 개념입니다.

왜냐하면 머신러닝의 목적은 결국 비용함수를 최소화하는 최적의 parameter를 찾아야 하는데,

이때 이 비용함수가 convex라면 1계 미분한 값이 0이 되는 지점의 함수값은 minimum이 되기 때문이죠.

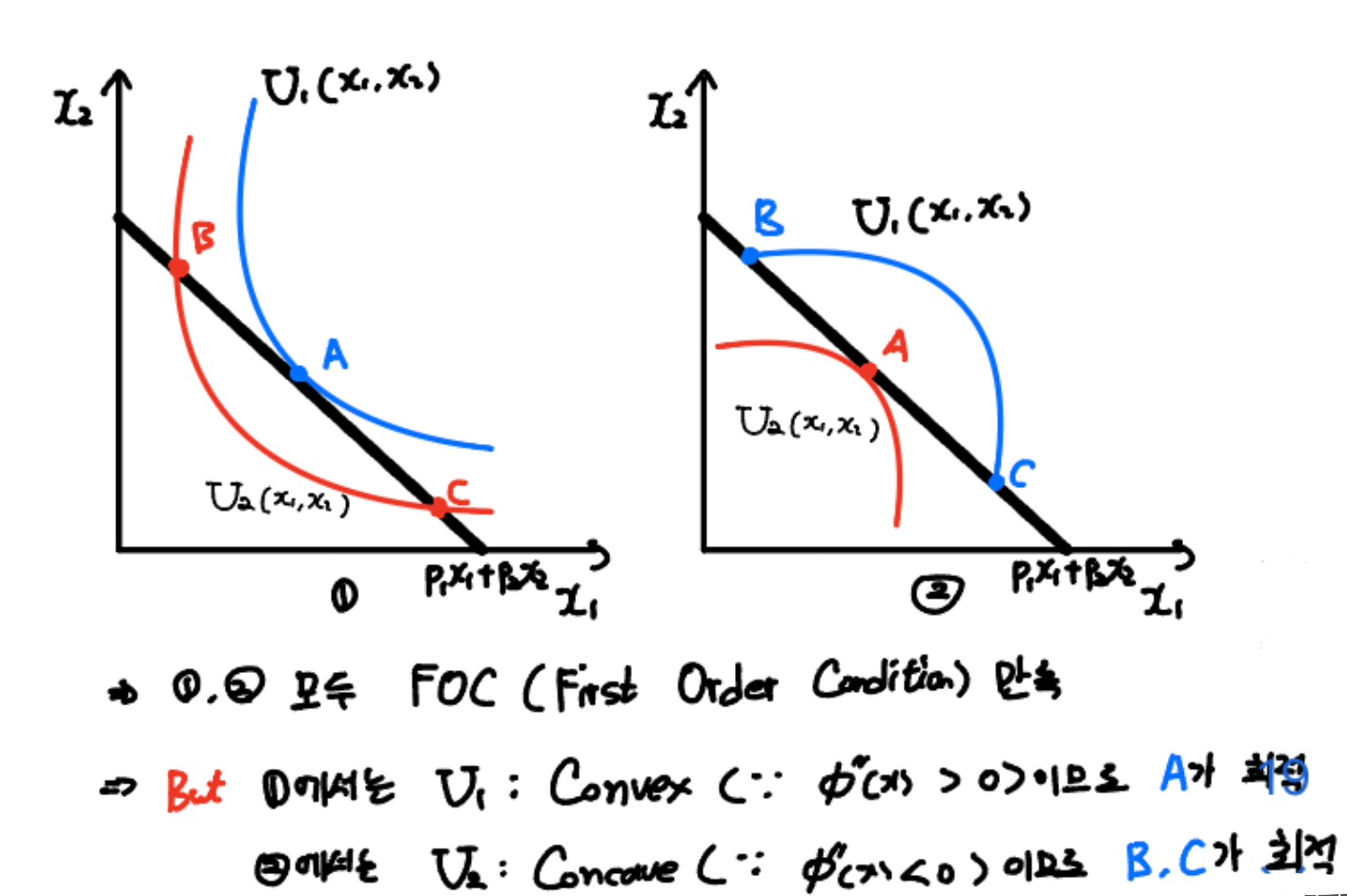

이해를 돕기 위해 경제학에서 효용극대화문제를 살펴보겠습니다.

재화 $x_1, x_2$에 대하여 효용함수 $U_1(x_1, x_2)$, $U_2(x_1, x_2)$, 그리고 예산 제약선 $p_1x_1 + p_2x_2$가 주어져 있다고 합시다.

그리고 일반적으로 예산제약선과 효용함수가 접하는 지점에서 효용이 극대화된다고 우리는 알고 있습니다.

좌측과 우측 모두 A지점에서 효용함수와 예산제약선이 접하는데요. 즉 효용함수의 1계 미분이 0이 되는 지점이죠.

다만 차이점이 있습니다.

좌측은 효용함수 $U_1$와 $U_2$ 모두 예산제약선과 만나지만, 접하는 A와 달리 B,C 지점은 접하는 지점이 아니므로 최적점이 아닙니다.

그리고 효용함수 또한 아래로 볼록한 형태인 Convex이므로 A가 최적의 minimum임을 알 수 있죠.

하지만 우측에서 효용함수는 위로 볼록한 Concave이기 때문에 예산제약선과 접하는 A 지점이 최적점이 아닙니다.

minimum을 찾아야하는데 이 경우는 maximum이므로 오히려 예산제약선과 교차되는 B, C 지점이 최적점이 됩니다.

이러한 이유 탓에 최적화 문제에서 주어진 함수의 형태가 Convex임을 알 수 있다면 굳이 2계 미분하지 않아도 1계 미분한 값이 0일 때 minimum임을 알 수 있습니다.

Convex임을 알 수 없다면, 1계 미분이 0이 된다는 조건이 충분조건이 아닌 필요조건이 되고,

그러므로 이계도함수를 구하여 0보다 큼을 보여야 합니다.

2. 젠센 부등식

어쩌다보니 컨벡스 함수에 대한 설명이 길어졌네요.

이번에 소개할 젠센 부등식(Jensen's Inequality)은 함수의 볼록성과 기댓값을 이용한 유용한 확률 부등식입니다.

옌센 부등식이라고도 하지만, 저는 젠센 부등식이라고 하겠습니다.

사실 젠센 부등식말고도 기댓값을 활용한 유명한 확률 부등식이 몇개 있습니다.

대표적으로 마르코프 부등식과 쳬비셰프 부등식인데요. 지난번 기초통계학 카테고리에서 다뤘으니 생략하겠습니다.

2020.05.26 - [Statistics/Basic Statistics] - [기초통계학] 마르코프 부등식(Markov Inequality)

[기초통계학] 마르코프 부등식(Markov Inequality)

Review 참고 포스팅 : 2020/05/18 - [Statistics/Basic Statistics] - [기초통계학] 확률변수와 기댓값, 분산 [기초통계학] 확률변수와 기댓값, 분산 Review 참고 포스팅 : 2020/05/15 - [Statistics/Basic Statistics] - [기초통

datalabbit.tistory.com

2020.06.24 - [Statistics/Basic Statistics] - [기초통계학] 체비셰프 부등식(Chebyshev Inequality)

[기초통계학] 체비셰프 부등식(Chebyshev Inequality)

Review 참고 포스팅 : 2020/05/26 - [Statistics/Basic Statistics] - [기초통계학] 마르코프 부등식(Markov Inequality) [기초통계학] 마르코프 부등식(Markov Inequality) Review 참고 포스팅 : 2020/05/18 - [Statistics/Basic Statisti

datalabbit.tistory.com

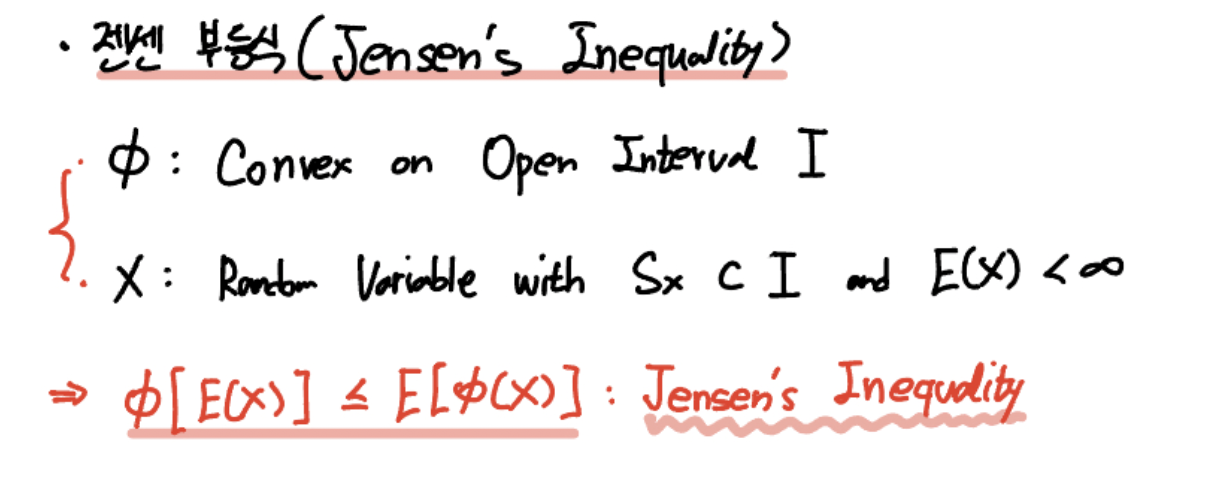

각설하고 젠센 부등식은 다음과 같습니다.

함수 $\phi$를 개구간 $I$에서 정의된 Convex함수라고 하겠습니다.

그리고 support $S_x$ 를 갖고, 기댓값을 정의할 수 있는 확률변수 X를 가정하겠습니다.

이때 다음을 만족하는 부등식을 젠센 부등식이라고 합니다.

$$ \phi [ E(X) ] \, \leq \, E[ \phi (X) ]$$

즉 주어진 함수가 Convex라면, 기댓값의 함수값이 함수값의 기댓값보다 항상 작거나 같다는 것입니다.

한번 젠센 부등식을 유도해보겠습니다.

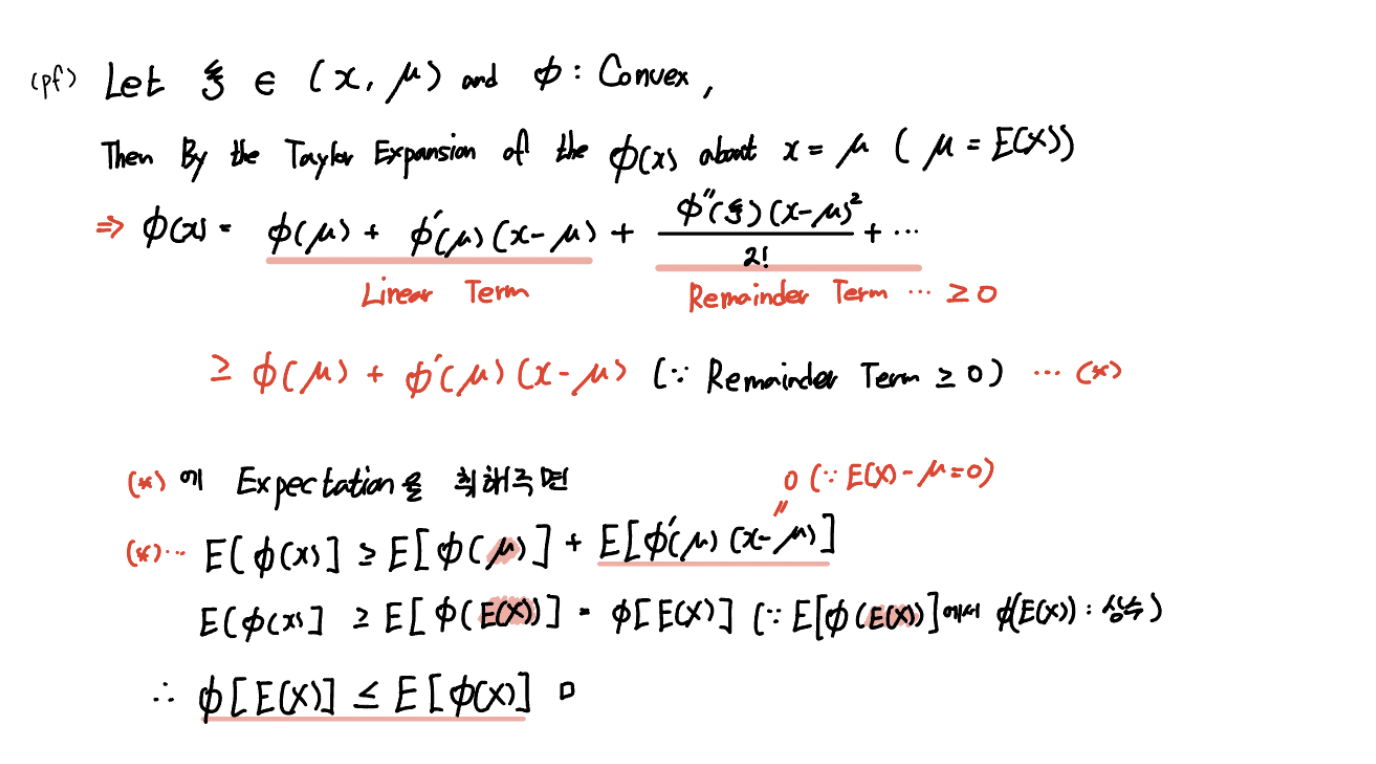

주어진 함수 $\phi(x)$를 $ x = \mu ( = E(X))$에서 테일러 급수로 확장하면 다음과 같습니다.

$$ \phi(x) \, = \, \phi(\mu) + \phi'(\mu)(x - \mu) + \frac{\phi''(\xi)(x-\mu)}{2!} + \cdots $$

여기서 $\phi( \mu ) + \phi'(\mu )(x - \mu )$ 을 제외한 나머지 항을 Remainder Term(나머지 항)으로 처리하겠습니다.

이때 Remainder Term은 당연히 0보다 크거나 같겠죠. $\phi$는 Convex이므로 이계도함수는 0보다 크거나 같고, $(x-\mu)^2$도 0보다 크거나 같으니깐요.

그러므로 $ \phi(x) \, \geq \, \phi(\mu) + \phi'(\mu)(x - \mu)$ 가 성립합니다.

여기서 양변에 Expectation을 취해주면 결과는 위 전개과정에 의해 $ \phi [ E(X) ] \, \leq \, E[ \phi (X) ]$ 이 됩니다.

아직까지는 젠센 부등식이 와닿지 않으실 것 같습니다. 와닿으신다면 다행이고요.

와닿지 않는 분들을 위해 젠센 부등식을 좀 더 직관적으로 설명해보겠습니다.

확률변수 X를 이산확률변수라고 생각해봅시다.

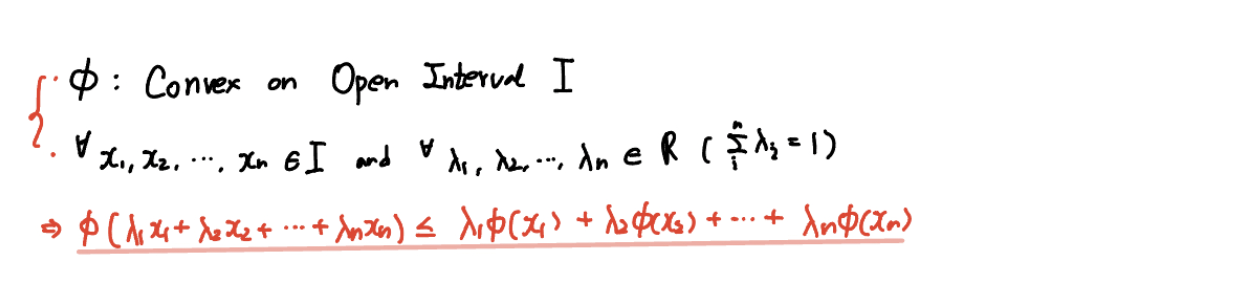

구간 $I$에 대하여 $x_1, x_2, ..., x_n \, \in \, I$이고, $\lambda$의 총합이 1이 되는 n개의 양의 실수 $\lambda$를 가정합시다.

기댓값을 사용하지 않고 위 젠센 부등식의 틀에 맞춰서 표기하면 다음과 같습니다.

$$ \phi( \lambda_1 x_1 + \lambda_2 x_2 + \cdots+ \lambda_n x_n) \, \leq \, \lambda_1 \phi(x_1) + \lambda_2 \phi(x_2) + \cdots + \lambda_n \phi(x_n) $$

이게 어떤 의미일까요?

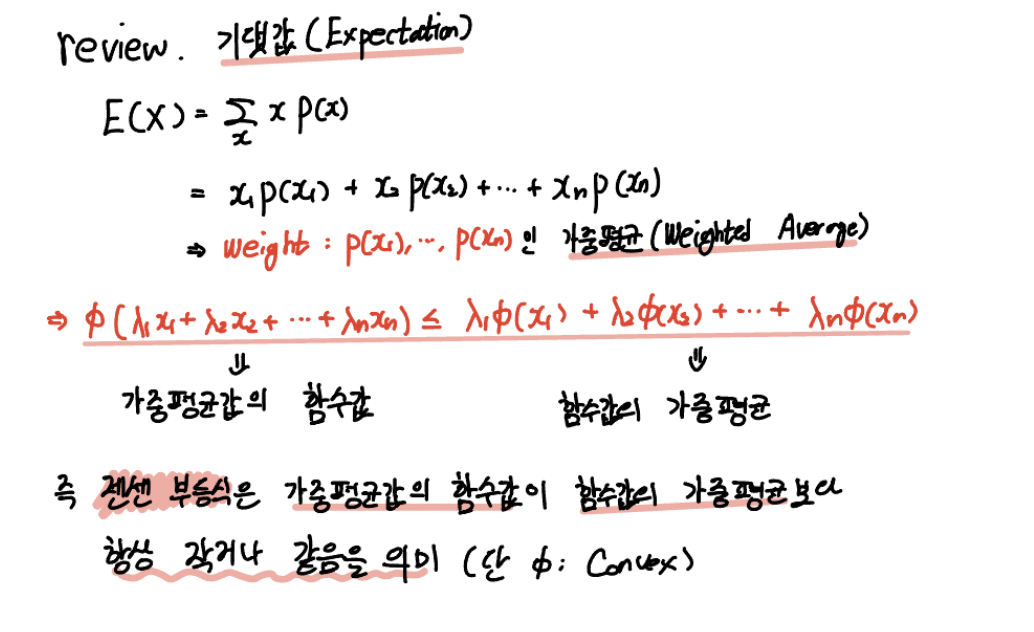

이해하기 위해 기댓값의 개념을 다시 상기해봅시다.

기댓값은 가중치가 확률 $p(x_i)$인 확률변수 $X$의 가중평균(Weighted Average)라고 했었죠.

즉,위 부등식에서 좌변 $\phi(\lambda_1 x_1 + \lambda_2 x_2 + \cdots + \lambda_n x_n)$은 가중평균값의 함수값이고,

우변 $\lambda_1 \phi(x_1) + \lambda_2 \phi(x_2) + \cdots + \lambda_n \phi(x_n)$은 함수값의 가중평균이라는 거죠!

그러므로 젠센 부등식은 가중평균값의 함수값이 함수값의 가중평균보다 항상 작거나 같음을 의미하겠네요!

이러면 좀 직관적으로 이해되실 거라 생각합니다.

이러한 젠센 부등식을 이용하면 여러 유용한 사실들을 도출할 수 있습니다.

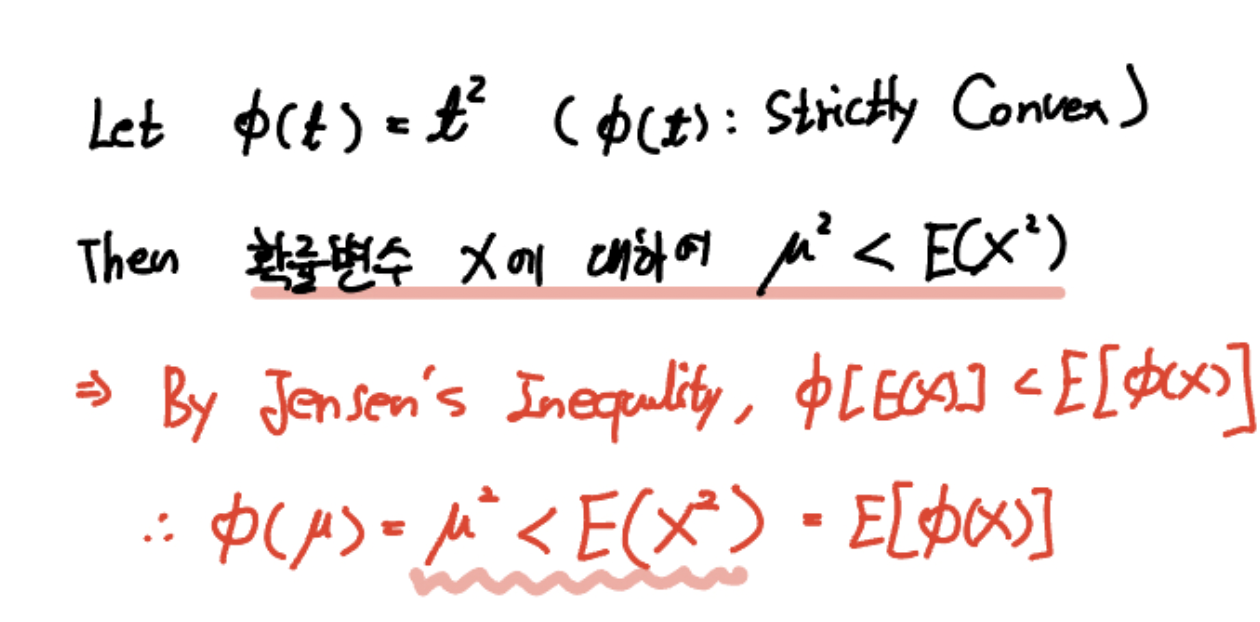

예를 들어 $\phi(t) \, =\, t^2$라고 하면 확률변수 X에 대하여 항상 X의 기댓값의 제곱, X의 1차 적률의 제곱은 X의 2차 적률보다 작다는 사실을 알 수 있습니다.

여기서 주어진 함수 $\phi(t)$ 는 Strictly Convex임은 자명한 사실이고요.

그렇다면 젠센 부등식에 의해서 $\phi [ E(X) ] < E[\phi(x)]$가 성립하니,

$\phi[E(X)]$ 가 $\mu^2$이고, $E[\phi(X)]$는 $E(X^2)$이므로 1차 적률의 제곱은 항상 2차 적률보다 작습니다.

본의 아니게 생각보다 젠센 부등식보다 컨벡스의 비중이 컸던 포스팅이었던 것 같습니다.

처음으로 포스팅 할 때 LaTex를 써봤는데 조금 번거롭긴 하지만 훨씬 퀄리티가 높아진 것 같네요. 앞으로 적극 활용해보겠습니다.

다음 포스팅에서는 하나의 확률변수에서 2개 이상의 확률변수의 분포로 확장하여 다변량 분포에 대해 다뤄보겠습니다.

감사합니다.

잘 읽으셨다면 게시글 하단에 ♡(좋아요) 눌러주시면 감사하겠습니다 :)

(구독이면 더욱 좋습니다 ^_^)

* 본 블로그는 학부생이 운영하는 블로그입니다.

따라서 포스팅에 학문적 오류가 있을 수 있으며, 이를 감안해서 봐주시면 감사하겠습니다.

- 간토끼(DataLabbit)

- B.A. in Economics, Data Science at University of Seoul